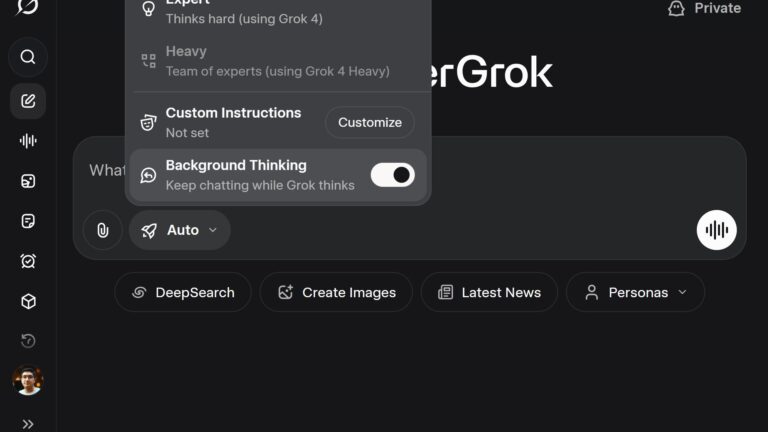

O Grok, da xAI, está testando um recurso chamado Background Thinking. A captura de tela que circula hoje mostra um botão que habilita o modelo a “continuar pensando enquanto você conversa”. Para o ecossistema de IA, isso aponta para uma nova fase: agentes realmente úteis, capazes de trabalhar em segundo plano enquanto seguimos com outras tarefas.

Se confirmado, é um salto importante na direção de experiências mais fluidas e produtivas em aplicações de IA.

O que é background thinking no Grok

Background thinking significa permitir que a IA mantenha processos ativos sem bloquear a conversa principal. Em prática, o usuário pode iniciar uma solicitação mais pesada e seguir dialogando no chat, enquanto o modelo continua raciocinando, consultando fontes ou executando passos definidos.

A promessa é simples e poderosa: menos espera explícita, mais continuidade, mais resultados entregues “quando ficarem prontos”.

Por que isso importa agora

O mercado está migrando de simples prompts para fluxos orientados a objetivos. Em vez de respostas instantâneas e rasas, as empresas querem entregáveis: relatórios, comparativos, análises, planilhas, rascunhos de código e monitoramento de sinais externos.

Sem processamento em segundo plano, tudo isso depende de timeouts, abas abertas e sessões que expiram. Com Background Thinking, o Grok pode:

- Reduzir atrito em tarefas longas.

- Priorizar recursos entre múltiplos pedidos.

- Notificar quando terminar, preservando o contexto.

Em um cenário onde copilotos corporativos viraram o novo padrão, esse diferencial conta.

Como pode funcionar na prática

Sessões persistentes e estado

Para “pensar” enquanto você segue conversando, a IA precisa preservar estado. Ou seja, lembrar onde parou, quais sub-tarefas abriu e quais dados já coletou. Isso viabiliza uma linha de raciocínio contínua, mesmo se você mudar de assunto por alguns minutos.

Tarefas assíncronas

O usuário dispara uma tarefa de longa duração (ex.: varrer documentos, comparar concorrentes, gerar um estudo) e acompanha atualizações por mensagens de progresso. A entrega final chega quando houver confiança de qualidade.

Planejamento em múltiplos passos

O background thinking favorece planejamento hierárquico: decompor objetivos em subtarefas, chamar ferramentas, reavaliar resultados e iterar sem intervenção manual a cada passo.

Memória e contexto

Para não “recomeçar do zero”, o Grok precisa de memória curta e longa. A curta mantém o fio da conversa; a longa guarda preferências, fontes confiáveis e formato de saída desejado. Isso eleva consistência e reduz retrabalho.

Impactos para criadores e empresas

Para marketing e conteúdo. Pesquisas, briefings, roteiros e varreduras de tendências podem rodar em segundo plano, com entregas em lotes. Você segue escrevendo enquanto a IA minera dados e retorna insights com referências.

Para produto e engenharia. Backlogs de bugs, impacto de releases e análises de logs podem ser agendados. A IA prepara diffs, PR notes e testes, e você aprova quando chegar.

Para dados e analytics. Rotinas de checagem em fontes públicas ou internas podem rodar periodicamente. Quando o sinal esperado surgir, o agente avisa e explica o porquê.

Para vendas e CS. Preparação de briefs e follow-ups pode ocorrer enquanto a conversa com o cliente continua. No fim do call, o pacote de entregáveis já está pronto.

Riscos e cuidados

Transparência. Trabalhos em segundo plano exigem visibilidade: fila de tarefas, status, custos estimados e logs do que foi feito.

Privacidade e segurança. Se o agente acessa dados enquanto você não está olhando, é crucial definir limites claros. Quais pastas, quais APIs, quais ambientes? Quem aprova chamadas sensíveis?

Custos. Processamento contínuo sem guardrails pode gerar despesas inesperadas. É importante ter alertas, cotas e políticas de cancelamento.

Qualidade e verificação. Quando a IA executa muitas etapas sem supervisão, aumenta a necessidade de checagem automática e validação humana antes da entrega final.

Como isso se compara ao restante do mercado

O movimento do Grok se alinha ao avanço geral dos agentes de IA. Em outras plataformas, vemos componentes para execução assíncrona, ferramentas integradas, memória e estado conversacional. O diferencial aqui é empacotar tudo de forma simples para o usuário final, com um toggle claro e uma experiência que não quebra o fluxo da conversa.

Se a implementação do Grok for estável e acessível, a xAI pode acelerar o uso de agentes no dia a dia, especialmente para quem já vive dentro do ecossistema X.

O que observar nos próximos dias

- Disponibilidade. É um teste limitado ou lançamento amplo?

- APIs. Haverá endpoints para iniciar, listar e cancelar tarefas em segundo plano?

- Notificações. O Grok vai sinalizar no chat, por push ou por e-mail?

- Ferramentas. Quais integrações nativas estarão disponíveis para esses fluxos?

- Controle de custos. Haverá cotas, limites por tarefa e relatórios de uso?

- UX. Como será a visualização da fila e do histórico de background thinking?

Grok e o próximo passo do Background Thinking

Se a xAI cravar o Background Thinking como padrão, entraremos na fase em que “conversar” com a IA e “delegar trabalhos” serão coisas simultâneas. Mais do que um recurso, isso consolida a tendência dos agentes orientados a objetivos: menos prompt, mais resultado.

Para o mercado, a mensagem é clara. A disputa não é só de qualidade de saída, e sim de orquestração inteligente: estado persistente, execução assíncrona, memória útil, integração com ferramentas e clareza de custos. É isso que transforma IA de “chat esperto” em infraestrutura de trabalho.